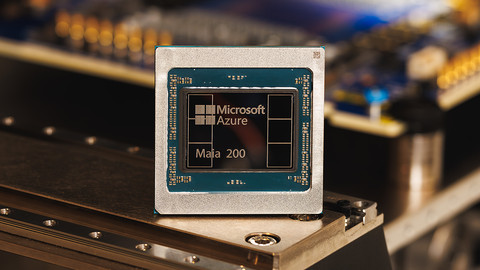

Microsoft resmi meluncurkan chip terbaru Maia 200, prosesor khusus yang dirancang untuk mempercepat dan mengefisienkan proses inferensi kecerdasan buatan (AI). Perusahaan menyebut Maia 200 sebagai tulang punggung silikon untuk menjalankan model AI skala besar dengan konsumsi daya lebih rendah.

Maia 200 merupakan penerus Maia 100 yang diperkenalkan pada 2023. Chip ini membawa peningkatan teknis signifikan.

Microsoft membekali Maia 200 dengan lebih dari 100 miliar transistor. Kinerjanya mencapai lebih dari 10 petaflops pada presisi 4-bit dan sekitar 5 petaflops pada presisi 8-bit, jauh lebih tinggi dibandingkan generasi sebelumnya.

Inferensi adalah tahap komputasi saat model artificial intelligence dijalankan untuk menghasilkan jawaban, berbeda dengan proses pelatihan model. Seiring bisnis AI berkembang, biaya inferensi menjadi komponen besar dalam biaya operasional.

Perusahaan teknologi kini berlomba mencari cara untuk menekan biaya tersebut tanpa mengorbankan performa. Microsoft berharap Maia 200 bisa menjawab tantangan itu.

"Secara praktis, satu node Maia 200 dapat dengan mudah menjalankan model-model terbesar saat ini, dengan ruang kapasitas yang masih luas untuk model yang lebih besar di masa depan," kata Scott Guthrie, Executive Vice President, Cloud + AI Microsoft, dalam pernyataan resmi.

Peluncuran Maia 200 juga mencerminkan tren industri teknologi yang mulai mengembangkan chip sendiri. Langkah ini bertujuan mengurangi ketergantungan pada GPU Nvidia yang selama ini menjadi komponen utama komputasi AI.

Google memiliki TPU yang tersedia melalui layanan cloud, sementara Amazon mengembangkan chip akselerator AI Trainium, dengan versi terbaru Trainium3 meluncur pada Desember 2025 lalu. Chip-chip ini membantu memindahkan sebagian beban komputasi dari GPU Nvidia dan menekan biaya perangkat keras.