Kebijakan publik semakin sering berbicara tentang machine learning, big data, dan kecerdasan buatan (AI) sebagai tulang punggung transformasi pelayanan negara.

Pemerintah menyongsong era digital dengan memanfaatkan algoritma untuk mempercepat layanan, meningkatkan efektivitas program sosial, dan memperbaiki tata kelola administrasi.

Namun, ketika keputusan publik mulai diambil dengan bantuan algoritma, muncul pertanyaan penting yang kerap terlewatkan: Siapa yang bertanggung jawab ketika sistem gagal?

Dalam sebuah kebijakan publik, akuntabilitas adalah fondasi esensial. Tanpa itu, warga negara kehilangan jalur aduannya ketika haknya dilanggar atau saat keputusan algoritmik memicu ketidakadilan.

Realitas 2025 menunjukkan peningkatan penggunaan algoritma dalam layanan publik di Indonesia, mulai dari penentuan prioritas bantuan sosial hingga penyaringan calon penerima layanan kesehatan berbasis risiko.

Algoritma telah masuk ke ruang kebijakan secara luas, tetapi regulasi yang mengaturnya belum seimbang dengan frekuensi penggunaan.

Penetrasi internet Indonesia terus meningkat menurut APJII 2025, penetrasi menjulang di atas 80 persen, tetapi pemanfaatan data besar dan sistem otomatis belum diikuti oleh kehati-hatian terhadap keadilan, transparansi, dan akuntabilitas keputusan algoritmik.

Tulisan ini menegaskan bahwa ketika kebijakan publik mulai bergantung pada algoritma, negara tidak boleh melepaskan tanggung jawab atas keputusan yang dihasilkan sistem otomatis apa pun namanya.

Algoritma dan Kebijakan Publik: Efisiensi tanpa Akuntabilitas?Dalam lapangan praktik, algoritma dipandang sebagai solusi efisiensi birokrasi dan perbaikan kebijakan berbasis data. Sistem rekomendasi digunakan untuk menyeleksi penerima bantuan sosial, analitik prediktif untuk alokasi sumber daya kesehatan, serta scoring otomatis untuk layanan perizinan dan pembayaran pajak.

Banyak institusi pemerintah menaruh optimisme bahwa keputusan otomatis akan mengurangi bias manusia, mengurangi korupsi, dan mempercepat layanan.

Namun, optimisme ini sering kali hanya dilandasi asumsi efisiensi, bukan refleksi atas konsekuensi sosial dan nilai publik. Algoritma mengambil keputusan berdasarkan data historis.

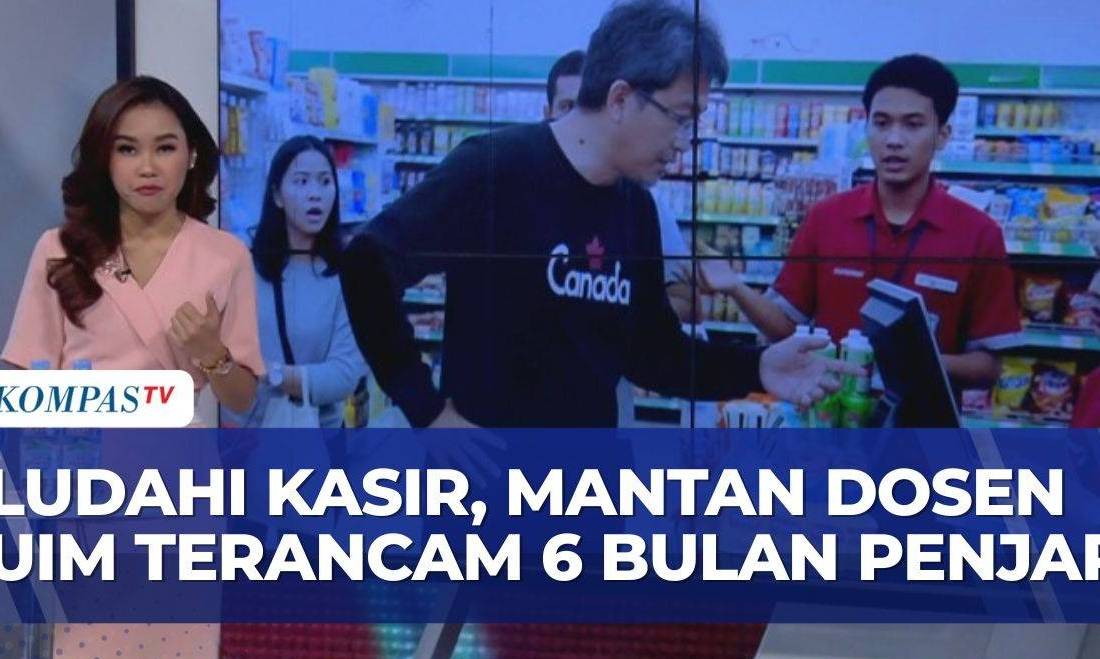

Jika data historis itu sendiri mengandung bias—misalnya ketidakterjangkauan layanan di daerah tertentu, kurangnya representasi kelompok marginal, atau kesalahan input administratif—algoritma akan mereplikasi bias tersebut dalam bentuk keputusan yang tampak objektif, tetapi sebenarnya diskriminatif secara sistemik.

Pengalaman negara-negara lain menunjukkan betapa algoritma bisa menciptakan ketidakadilan yang terstruktur. Di beberapa negara, sistem penilaian risiko kredit otomatis menolak permohonan dari warga di wilayah tertentu yang kurang terlayani bank, bukan semata karena risiko kredit, melainkan karena kurangnya rekam jejak historis dalam data.

Di Indonesia, penggunaan algoritma serupa tanpa audit independen berpotensi memperkuat ketimpangan yang justru menjadi masalah kebijakan sosial utama.

Namun realitasnya di Indonesia, struktur pengawasan terhadap algoritma yang digunakan dalam kebijakan publik masih rapuh. UU Perlindungan Data Pribadi (UU PDP) telah disahkan, tetapi cakupannya tidak secara eksplisit mengatur algoritma sebagai entitas pengambil keputusan.

Situasi ini menciptakan ruang abu-abu: ketika algoritma memutuskan status bantuan, penetapan prioritas layanan, atau akses publik lainnya, siapa yang bertanggung jawab ketika keputusan tersebut merugikan warga?

Apakah pemerintah sebagai pengguna sistem? Penyedia teknologi sebagai pembuat algoritma? Atau algoritma itu sendiri? Jawabannya implisit, tanggung jawab final tetap berada pada negara. Ini bukan sekadar posisi normatif, melainkan juga posisi yang menjamin hak warga dalam negara demokratis.

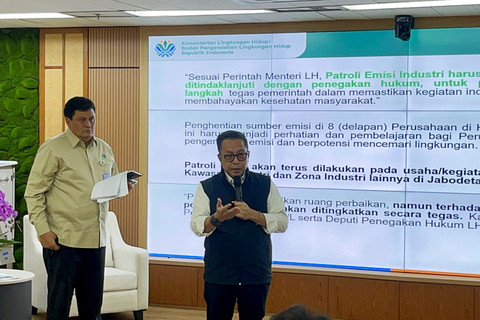

Ketimpangan Transparansi, Audit, dan Akuntabilitas AlgoritmaPemerintah Indonesia telah mendorong digitalisasi layanan publik melalui Sistem Pemerintahan Berbasis Elektronik (SPBE), integrasi data melalui Satu Data Indonesia, dan percepatan layanan digital. Namun, sejauh mana publik bisa memahami atau mengawasi algoritma yang dipakai dalam layanan itu?

Transparansi algoritma merupakan isu penting. Banyak sistem yang beroperasi sebagai black box. Artinya, logika pengambilan keputusan tidak dapat diakses atau dipahami oleh publik, apalagi oleh warga yang terkena dampaknya.

Jika warga ditolak akses layanan karena skor otomatis, tidak ada mekanisme penjelasan yang memadai. Ini jelas merongrong prinsip akuntabilitas publik.

Negara lain telah mengadopsi prinsip audit algoritma independen. Misalnya, beberapa negara anggota Uni Eropa menerapkan algorithmic impact assessment sebagai bagian dari regulasi pra-implementasi teknologi otomasi pemerintah.

Audit semacam ini memeriksa potensi bias, kesalahan, dan risiko diskriminasi sebelum sistem dijalankan, serta menetapkan mekanisme klarifikasi bagi warga yang terdampak. Indonesia belum memiliki mekanisme serupa yang kuat dan berkewenangan tinggi.

Kasus di sektor kesehatan memperlihatkan potensi risiko ini secara jelas. Ketika sistem otomatis memetakan risiko pasien untuk layanan prioritas, warga di wilayah dengan data kesehatan elektronik tidak lengkap bisa diposisikan sebagai risiko rendah, padahal kenyataannya mereka justru paling membutuhkan layanan itu.

Ketika sistem semacam ini dijalankan tanpa kontrol publik, tanpa audit, dan tanpa jalur banding yang jelas, warga kehilangan hak fundamentalnya untuk mendapatkan layanan publik yang adil.

Ini bukan sekadar masalah teknis. Ia adalah masalah keadilan publik. Ketika algoritma menjadi aktor dalam kebijakan, dua dimensi penting harus dijamin: transparansi dalam proses algoritmik dan akuntabilitas penuh pembuat serta pengguna sistem atas keputusan yang diambil. Tanpa ini, efek sosial negatif dari algoritma publik akan semakin tajam.

Ketergantungan pada teknologi otomatis sering kali membuat negara mengadopsi solusi yang lebih cepat, tetapi kurang mempertimbangkan nilai-nilai sosial. Bias teknologi bukan hanya soal kesalahan input data, melainkan juga soal asumsi tentang apa itu risiko, siapa prioritas pelayanan, atau bagaimana kelayakan layanan diukur.

Ketika algoritma menyederhanakan kategori sosial yang kompleks menjadi skor numerik, kita harus bertanya: Siapa yang berada di balik asumsi itu?

Jawabannya sering kali kompleks: vendor teknologi, kontraktor sistem, pembuat model statistik, dan birokrat yang menjalankan sistem. Ketika tanggung jawab tersebar, akuntabilitas menjadi kabur.

Negara harus mengambil peran regulatif tertinggi dalam penggunaan teknologi publik, bukan sekadar mengadopsinya. Ketika negara menghadirkan layanan otomatis, negara pula yang harus menjamin bahwa keputusan otomatis tersebut dapat:

dipertanggungjawabkan kepada publik,

diperbaiki ketika terbukti bias,

dihapus jika merugikan kelompok tertentu secara sistemik.

Jika ini tidak terjadi, kita memasuki fase di mana birokrasi digital justru memperkuat ketidakadilan, bukan memecahkannya.

Rekomendasi Kebijakan PublikUntuk memastikan algoritma menjadi alat yang memperkuat pemerintahan yang adil dan bertanggung jawab, berikut rekomendasi kebijakan publik yang relevan dengan kondisi Indonesia saat ini.

1. Wajibkan Audit Algoritma Independen

Setiap sistem otomatis yang digunakan dalam pengambilan keputusan publik harus melalui audit algoritma independen sebelum dan sesudah implementasi. Hal ini bertujuan untuk mengidentifikasi bias, diskriminasi, dan dampak sosial negatif yang potensial.

2. Transparansi Algoritma

Pemerintah harus membuka akses publik terhadap explainability atau penjelasan logika algoritma dalam bahasa yang mudah dipahami warga, termasuk justifikasi variabel yang digunakan dalam setiap keputusan otomatis.

3. Mekanisme Banding dan Remediasi

Warga yang terkena dampak keputusan otomatis harus memiliki akses ke mekanisme banding yang cepat, efisien, dan adil—dengan opsi klarifikasi manusia (human review) atas keputusan algoritmik.

4. Regulasi Kuat atas Data Publik

UU Perlindungan Data Pribadi (UU PDP) perlu dilengkapi dengan ketentuan yang mengatur pengunaan data dalam konteks pengambilan keputusan otomatis, termasuk kewajiban data minimization, fairness, accountability, dan transparency.

5. Peningkatan Literasi Digital

Program literasi digital yang komprehensif harus mencakup pendidikan masyarakat tentang bagaimana algoritma bekerja, hak warga atas data mereka, dan cara memperjuangkan hak ketika sistem gagal.

Algoritma bukan sekadar kode. Ketika ia berfungsi dalam ruang kebijakan publik, ia menjadi aktor pembuat keputusan yang berdampak pada kehidupan warga.

Namun, aktor ini tidak dilahirkan oleh kehendak publik, tetapi dilahirkan oleh keputusan teknokrat dan logika pasar. Ketika keputusan publik diserahkan begitu saja kepada sistem otomatis tanpa akuntabilitas publik yang kuat, negara telah melangkah terlalu jauh ke dalam governance by machine.

Dalam demokrasi, keputusan publik apa pun bentuknya harus dipertanggungjawabkan secara politik dan moral. Mesin tidak memiliki moral, tetapi negara memiliki kewajiban menjaga hak warga, bahkan jika itu berarti menempatkan manusia kembali di belakang keputusan algoritma yang keliru.

Siapa yang bertanggung jawab saat sistem gagal? Jawabannya jelas: negara tetap memegang tanggung jawab akhir, bukan mesin, bukan vendor, dan bukan angka statistik.